Snowflake kündigt modernste KI an, um mit Ihren Daten zu sprechen, LLMs sicher anzupassen und Modellabläufe zu optimieren

Generative KI (GenAI) bietet Unternehmen die Möglichkeit, umfassende Einblicke aus unstrukturierten Datenquellen wie Dokumenten, Kundenbewertungen und Bildern zu gewinnen. Sie bietet auch die Möglichkeit, jede Interaktion zwischen Kund:innen und Mitarbeitenden mit Daten neu zu gestalten, über dialogorientierte Anwendungen. Diese Chancen bringen auch Herausforderungen für Daten- und KI-Teams mit sich, die Datensicherheit und Datenschutz priorisieren und gleichzeitig schnell neue Anwendungsfälle im gesamten Unternehmen implementieren müssen.

Gleichzeitig ist maschinelles Lernen (ML) in etablierten Bereichen der prädiktiven KI wie Empfehlungssystemen, Bedarfsprognosen und Betrugsprävention nach wie vor wertvoll. Doch da sich die Infrastrukturanforderungen von generativer KI von denen von ML unterscheiden, werden Daten systemübergreifend dupliziert, was zu unkontrollierten Daten-Pipelines führt, die für zusätzliche Betriebskosten sorgen und Datenrisiken erhöhen.

Snowflake hat es sich zur Aufgabe gemacht, Unternehmen dabei zu unterstützen, weiterhin ein neues Maß an Produktivität und Erkenntnissen zu erschließen, und zwar auf eine effiziente, einfache und zuverlässige Weise, unabhängig davon, ob der Anwendungsfall generative KI, maschinelles Lernen oder beides nutzt.

- Unkompliziert: Wir sorgen dafür, dass nicht nur einige wenige Fachkräfte im technischen Bereich von KI profitieren. Das tun wir, indem wir komplett verwaltete Dienste und eine Infrastruktur anbieten, die einfach funktionieren und auf die über Code- (SQL, Python, REST) oder auch über No-Code-Schnittstellen zugegriffen werden kann.

- Effizient: Wir optimieren den Lebenszyklus von der Entwicklung bis zur Bereitstellung mit hochwertigen Modellen und Diensten, die neben den Unternehmensdaten laufen.

- Bewährt: Wir erweitern Governance und detaillierte rollenbasierte Zugriffskontrollen, auf die Tausende von Unternehmen vertrauen, von Daten auf Modelle − auf unkomplizierte Weise.

„Unsere Mission bei Zoom Communications besteht darin, als eine zentrale Plattform grenzenlose menschliche Interaktionen zu ermöglichen. Hierzu wollen wir alle Mitglieder unseres Teams dabei unterstützen, KI auf sichere Weise zu verwenden, sodass wir unseren Kund:innen einen besseren Service bieten können. Indem wir die einheitliche, anwenderfreundliche und sichere Snowflake-Plattform für generative KI und maschinelles Lernen nutzen, ist es uns möglich, künstliche Intelligenz weiter zu demokratisieren, um Daten auf effiziente Weise in bessere Kundenerfahrungen zu verwandeln.“

Awinash Sinha, Corporate CIO, Zoom Communications

Mit diesem Ansatz ermöglichen wir unseren Kunden bei Snowflake auch weiterhin, KI in jeden Bereich ihres Geschäfts einzubringen und folgende Maßnahmen zu ergreifen:

- Treten Sie mithilfe hochmoderner KI in einen Dialog mit Ihren Daten: Das Stellen von Fragen zu unstrukturierten Daten wie Dokumenten und strukturierten Daten wie Verkaufstransaktionen ist jetzt ohne komplexe Infrastruktur oder benutzerdefinierte LLM-Orchestrierung über zwei Chat-APIs möglich. Cortex Analyst (demnächst in Public Preview), das mit Meta Llama 3 und Mistral Large Modellen entwickelt wurde, ermöglicht es Entwickler:innen, geschäftlichen User:innen Einblicke bereitzustellen – mit einem Service, der Text in Antworten aus analytischen Tabellen in Snowflake und Cortex Search (demnächst in Public Preview) umwandelt, um Fragen zu Dokumenten und anderen unstrukturierten Texten zu stellen.

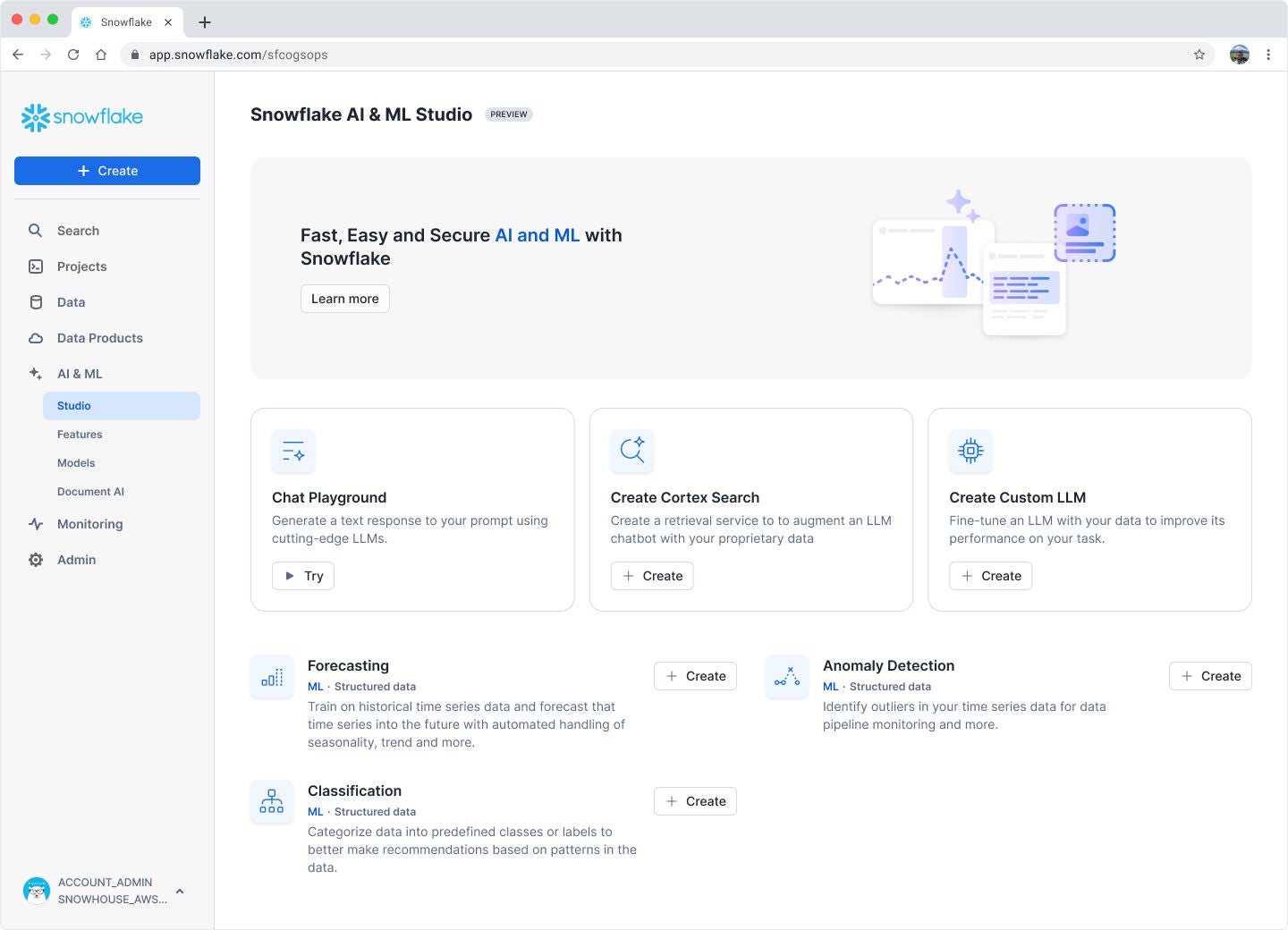

- Ermöglichen Sie mehr Teams den sicheren Einsatz von KI: Neben den benutzerfreundlichen SQL- und Python-Funktionen, die von Datenteams in Snowflake Notebooks (Public Preview) genutzt werden, spricht Snowflake auch mehr Nutzende über Snowflake AI & ML Studio (Public Preview für ML-Modelle, Private Preview für LLMs) für die No-Code-KI-Entwicklung an. Damit Entwickler:innen aus externen Apps schnell mit LLMs in Snowflake Cortex AI interagieren können, kommt zusätzlich zu den vorhandenen SQL- und Python-Funktionen REST API-Unterstützung. Geschäftsteams können über eine einfache Natural Language Interface in Document AI (demnächst allgemein verfügbar) Inhalte und Analysewerte aus PDFs und anderen Dokumenten extrahieren, ohne hierfür KI-Kenntnisse zu benötigen.

- Einfache Erstellung anwendungsfallspezifischer generativer KI: Damit Unternehmen die LLM-Performance steigern und personalisierte Erfahrungen ohne operative Komplexität bieten können, ist die serverlose Optimierung der Grundlagenmodelle jetzt in Public Preview. Die Optimierung kann sowohl über No-Code-Experience in Snowflake AI & ML Studio als auch über die codebasierte API erfolgen.

- Beschleunigung und Skalierung von Feature- und Modellvorgängen: Die Entwicklung, Bereitstellung und Verwaltung umfangreicher Features und Modelle wird immer einfacher. Dies ist möglich mit Notebooks, die für die automatische Ausführung (Public Preview) geplant werden können, Snowflake Feature Store (Public Preview), um die Verwendung und Verwaltung von Features zu optimieren, und der Snowflake Model Registry, um Modelle zu verwalten, die in Snowflake oder einer anderen Plattform trainiert wurden. Und um ein einheitliches Erlebnis für alle benutzerdefinierten Modelle zu bieten, einschließlich optimierter LLMs mit Snowflake Cortex AI.

Sprechen Sie mit Ihren Daten dank modernster KI

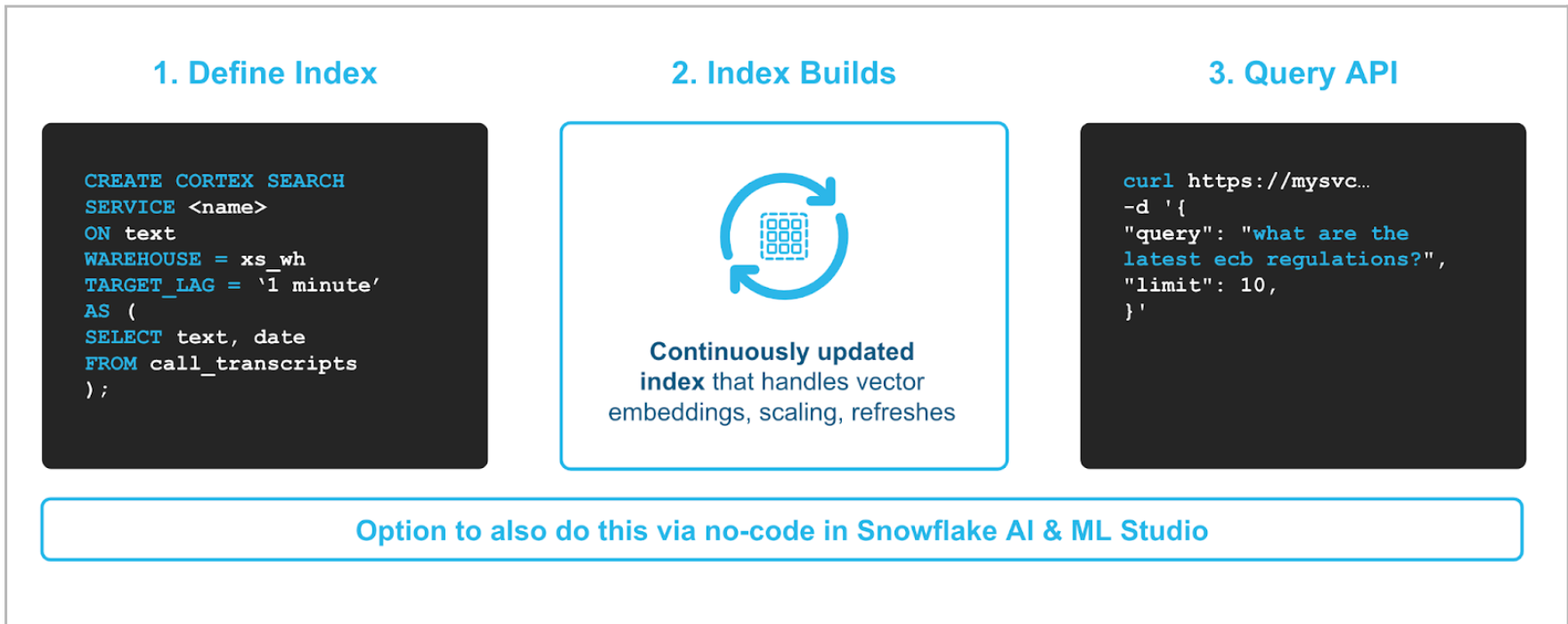

Mit Cortex Search, das demnächst in Public Preview verfügbar ist, können Sie ganz einfach mit Dokumenten und anderen textbasierten Datasets wie Wikis und FAQs sprechen. Mit Studio oder einem einzigen Befehl, bei dem Sie festlegen, welche Dokumente für die Suche bereitgestellt werden sollen, benötigen Sie nur wenige Klicks, um den Dokumentensuchdienst zum Laufen zu bringen (siehe Abbildung 1).

Um genauere Ergebnisse zu erzielen, nutzt Cortex Search modernste Abruf- und Ranking-Techniken. Cortex Search kombiniert semantische Suche und Keyword-Suche, die auf den neuesten Technologien von Neva und den Arctic Embed-Modellen des Snowflake AI Research-Teams basieren. So kann Cortex Search seinen Benutzer:innen hochwertige Ergebnisse ohne operative Komplexität bieten. Cortex Search kann mithilfe von vollständig verwalteter Vektoreinbettung und -abruf auf Millionen von Dokumenten mit einer Latenzzeit von weniger als einer Sekunde skaliert werden. Eine separate Vektordatenbank ist nicht erforderlich.

Mit Cortex Analyst, das demnächst in Public Preview verfügbar ist, können App-Entwickler:innen Anwendungen auf der Grundlage ihrer in Snowflake gespeicherten analytischen Daten erstellen. So erhalten geschäftliche Benutzer:innen die nötigen Dateneinblicke, indem sie ihre Fragen einfach in natürlicher Sprache stellen. Im Vergleich zum Snowflake Copilot, mit dem SQL-Entwickler:innen die Entwicklung von Snowsight beschleunigen können, indem sie Text in SQL umwandeln, wurde der Cortex Analyst entwickelt, um Fragen in Antworten zu verwandeln – und das in jeder Anwendung, mit der geschäftliche Benutzer:innen täglich interagieren. Um die hohe Genauigkeit zu gewährleisten, die geschäftliche Nutzende erwarten, um den Ergebnissen zu vertrauen und Maßnahmen zu ergreifen, übernimmt Snowflake die schwere Aufgabe, indem es modernste LLMs von Meta und Mistral AI kombiniert und Entwickler:innen lediglich auffordert, während der Einrichtung ein semantisches Modell bereitzustellen. Dieses semantische Modell bietet zusätzlichen Kontext zur spezifischen Terminologie und Datenmodellierungsstruktur des Unternehmens.

Ermöglichen Sie mehr Teams den Einsatz von KI

Snowflake AI & ML Studio, in Private Preview für LLMs, bringt No-Code-KI-Entwicklung zu Snowflake. Studio ist in Snowsight zugänglich, um auf interaktive Schnittstellen zuzugreifen, über die Teams schnell mehrere Modelle mit ihren Daten kombinieren und Ergebnisse vergleichen können, um die Bereitstellung für Anwendungen in der Produktion zu beschleunigen. Zu den interaktiven Erfahrungen von Studio gehört die Möglichkeit, Modelle für maschinelles Lernen zu erstellen, wie z. B. Prognosen. Künftig wird es auch eine Schnittstelle geben, um die Antworten mehrerer LLMs von einem einzigen Prompt zu vergleichen und auszuwerten, LLM-Optimierungen auszuführen und mehr. Insbesondere für GenAI-Anwendungsfälle erleichtert dieses No-Code-Erlebnis den Teams die Bewertung und Auswahl des neuesten Modells, das ihren Aufgaben- und Kostenzielen am besten entspricht.

Snowflake Notebooks helfen, ML-Workflows zu beschleunigen. Durch die nahtlose Integration der Experimentverfolgung mit Weights & Biases direkt in Notebooks entfällt die Kontextumstellung und der gesamte Lebenszyklus des maschinellen Lernens für die Entwicklung und Bereitstellung von Modellen wird optimiert. Wir sind gespannt, wie diese Integration weitere Effizienzsteigerungen für unsere Kundschaft ermöglicht.

Venky Yerneni, Manager, Solution Architecture, Weights & Biases

Snowflake Notebooks sind jetzt in Public Preview verfügbar. Hiermit können Datenteams, die SQL, Python oder beides beherrschen, interaktive Analysen durchführen, Modelle trainieren oder LLMs in einer integrierten zellbasierten Umgebung bewerten. Diese interaktive Entwicklungserfahrung beseitigt die Verarbeitungsgrenzen der lokalen Entwicklung sowie die Sicherheits- und Betriebsrisiken, die mit dem Verschieben von Daten in ein separates Tool einhergehen. Und da Notebooks in Streamlit-Bibliotheken integriert sind, können Sie den in einem Notebook entwickelten Code ganz einfach in Streamlit in Snowflake bereitstellen, um Einblicke in Form von interaktiven Anwendungen bereitzustellen.

Weitere Informationen zur Verwendung von Notebooks finden Sie in unserer Dokumentation oder in diesem Quickstart.

Document AI ist demnächst allgemein verfügbar und bietet ein neues Framework, mit dem Sie ganz einfach Inhalte wie Rechnungsbeträge oder Vertragsbedingungen aus Dokumenten extrahieren können – mit Arctic TILT, einem hochmodernen integrierten multimodalen LLM. Geschäftliche User:innen ohne technische Vorkenntnisse können über die Natural Language Interface festlegen, welche Felder oder Werte extrahiert werden müssen, und bei Bedarf das Modell optimieren, um bestimmte Dokumentformate besser zu verstehen. Um die gewünschten Felder kontinuierlich zu extrahieren, sobald neue Dokumente eingehen, kann das Modell dann über die SQL-Funktion PREDICT von den Data Engineers oder ML Engineers ausgeführt werden, die das Modell in Pipelines operationalisieren, die Downstream-Analytics oder ML-Modelle versorgen.

Benutzerdefinierte generative KI, sicher und einfach

Snowflake Cortex Fine-Tuning, jetzt in Public Preview, unterstützt die sichere und serverlose Anpassung einer Teilmenge von Meta- und Mistral-KI-Modellen. Sobald die Daten verfügbar sind, können Sie den Fine-Tuning-Prozess ganz einfach mit einer SQL-Funktion oder wenigen Klicks über Snowflake AI & ML Studio starten, ohne eine Infrastruktur verwalten zu müssen. Fine-tuned-Modelle stehen standardmäßig nur Ihnen zur Verfügung und können über Richtlinien, die über die Snowflake Model Registry definiert wurden, für andere freigegeben werden. User:innen, die Zugriff auf diese individuell angepassten Modelle haben, können sie genauso unkompliziert nutzen wie alle anderen von Cortex unterstützten LLMs.

Details zum Preis und zu den unterstützten Modellen finden Sie in unserer Dokumentation.

Cortex Guard ist schon bald allgemein verfügbar, um schädliche Inhalte im Zusammenhang mit Gewalt und Hass, Selbstschädigung und kriminellen Aktivitäten zu filtern. Sicherheitskontrollen können mühelos auf jedes LLM in Cortex AI angewendet werden, indem Sie die Guardrail-Einstellung verwenden, die jetzt Teil der COMPLETE-Funktion ist. Mit Cortex Guard können Unternehmen schnell Sicherheitskontrollen implementieren, die für die Bereitstellung von generativer KI in Produktionsanwendungen erforderlich sind.

Beschleunigen und skalieren Sie Feature- und Modelloperationen

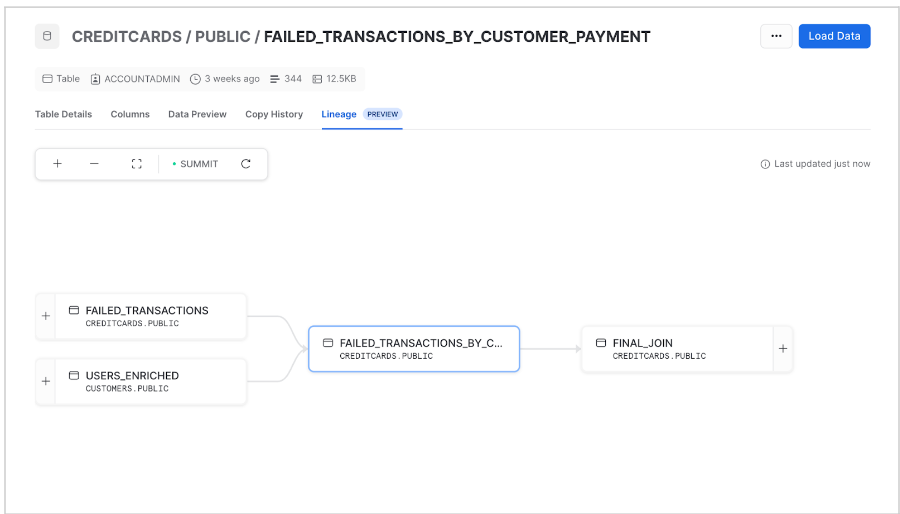

Mit Snowflake Horizon ML Lineage, in Private Preview, können Teams die End-to-End-Herkunft (Lineage) von Features, Datasets und Modellen von Daten bis hin zu Erkenntnissen verfolgen, um eine nahtlose Reproduzierbarkeit und vereinfachte Beobachtbarkeit zu gewährleisten. Um die Beziehung zwischen Daten und Modellen schnell abzubilden, wird in Snowsight eine Visualisierungsschnittstelle bereitgestellt.

Feature Store, in Public Preview, ist eine integrierte und zentralisierte Lösung zum Definieren, Verwalten, Speichern und Entdecken von Features. Diese Lösung, die in die breitere Suite von Komponenten von Snowflake ML fällt, ermöglicht Einheitlichkeit und Genauigkeit über verschiedene ML-Pipelines und Teams hinweg, unabhängig davon, ob die Features für Trainingsmodelle oder die laufende Inferenz verwendet werden. Im Rahmen dieser Public Preview können Features mit der Snowpark ML API über Snowflake Notebooks oder eine beliebige IDE definiert und verwaltet werden. Der Feature Store aktualisiert Daten aus Batch- und Streaming-Quellen automatisch schrittweise gemäß dem benutzerdefinierten Zeitplan und versorgt Teams mit den neuesten Informationen.

Weitere Informationen zu den Einstiegsmöglichkeiten finden Sie in unserer Dokumentation.

Mit Snowflake ML konnten wir einen großen Meilenstein in unserer Daten- und KI-Vision erreichen und unseren Kunden echte, persönliche Erfahrungen bieten. Durch die Umstellung von stundenlangen Inferenzjobs auf Prognosen nahezu in Echtzeit konnten wir eine Kostenreduzierung von 70 % und mehr Agilität erreichen.

Stefan Kochi, CTO, Paytronix

Model Registry ist allgemein verfügbar und erleichtert die Governance für alle ML-Modelle – unabhängig davon, ob Sie sie in Snowflake oder einem anderen ML-System trainiert haben. Durch die Integration von Modellen in Snowflake erhalten Teams den Vorteil eines zentralen Hubs zur Verwaltung von Modellen und den zugehörigen Metadaten. Außerdem profitieren sie von einer effizienteren Inferenz, indem sie Modelle dort ausführen, wo die Produktions-Features gespeichert und verwaltet werden.

Sehen Sie sich diesen Quickstart an, um zu erfahren, wie einfach es ist, ML-Modelle in Snowflake zu trainieren und zu kontrollieren.

Weitere Informationen und Ressourcen

Durch die Verwendung einer einheitlichen Plattform mit präziser Zugriffskontrolle für Daten und Modelle können Teams das Tempo beschleunigen, in dem sie KI auf effiziente, einfache und zuverlässige Weise in jeden Bereich ihres Unternehmens einbringen.

Probieren Sie es selbst aus mit unseren Quickstarts für generative KI und ML