Snowflake annonce une IA de pointe pour parler à vos données, personnaliser en toute sécurité les LLM et rationaliser les opérations des modèles

L’IA générative offre aux entreprises la possibilité d’extraire des informations à grande échelle à partir de sources de données non structurées, telles que des documents, des avis clients et des images. Elle offre également l’opportunité de réimaginer chaque interaction des clients et collaborateurs avec les données via des applications conversationnelles. Ces opportunités s’accompagnent également de défis pour les équipes data et IA, qui doivent privilégier la sécurité et la confidentialité des données tout en déployant rapidement de nouveaux cas d’usage dans toute l’entreprise.

Parallèlement, le machine learning (ML) reste précieux dans des domaines établis de l’IA prédictive, tels que les systèmes de recommandation, la prévision de la demande et la prévention des fraudes. Mais comme les besoins en infrastructure de l’IA générative diffèrent de ceux du ML, même au sein d’une même équipe, les données sont dupliquées entre les systèmes, ce qui conduit à des pipelines de données non gouvernés qui augmentent les coûts opérationnels et les risques liés aux données.

Snowflake s’engage à aider les entreprises à atteindre de nouveaux niveaux de productivité et d’informations de manière efficace, simple et fiable, que le cas d’usage utilise l’IA générative, le machine learning ou les deux.

- Simple : permettez à des profils non experts techniques d’utiliser l’IA, avec des services entièrement gérés et une infrastructure qui fonctionnent, tout simplement, et sont accessibles via des interfaces avec code (SQL, Python, REST) ou sans code.

- Efficace : rationalisez le cycle de vie du développement au déploiement grâce à des modèles et services de qualité exceptionnelle, qui s’exécutent là où se trouvent les données de votre entreprise.

- Fiable : rejoignez les milliers d’entreprises qui font déjà confiance aux contrôles d’accès granulaires basés sur les rôles, et étendez en toute simplicité ces contrôles et la gouvernance des données aux modèles.

L’objectif de Zoom Communications est d’être une plateforme unique qui permet aux humains de se connecter les uns aux autres sans restriction. Pour y parvenir, nous voulons donner à chacun des membres de l’équipe les moyens d’utiliser l’IA en toute sécurité pour mieux aider nos clients. Grâce à la plateforme conviviale et sécurisée de Snowflake pour l’IA générative et le machine learning, nous poursuivons la démocratisation de l’IA dans le but de transformer efficacement les données en une expérience client améliorée.

Awinash Sinha, Corporate CIO, Zoom Communications

Grâce à cette approche, chez Snowflake, nous continuons à permettre à nos clients d’intégrer l’IA dans tous les aspects de leur activité et de :

- Communiquer avec leurs données grâce à une IA de pointe : poser des questions sur des données non structurées, comme des documents, et des données structurées, comme des transactions commerciales, est désormais possible sans infrastructure complexe ou orchestration personnalisée de LLM à l'aide de deux API de chat. Cortex Analyst (bientôt disponible en public preview), conçu à l’aide des modèles Meta Llama 3 et Mistral Large, permet aux développeurs d’extraire des informations pour les utilisateurs métiers grâce à un service qui transforme du texte en réponses à partir de tableaux analytiques dans Snowflake et Cortex Search (bientôt disponible en public preview) pour poser des questions sur des documents et d’autres textes non structurés.

- Donner à plus d’équipes les moyens d’utiliser l’IA en toute sécurité : outre les fonctions SQL et Python conviviales utilisées par les équipes data dans les Snowflake Notebooks (public preview), Snowflake permet à davantage d’utilisateurs à développer l’IA sans codage via Snowflake AI & ML Studio (public preview pour les modèles de ML, private preview pour les LLM). Pour permettre aux développeurs d’interagir rapidement avec les LLM dans Snowflake Cortex AI à partir d’applications externes, la prise en charge des API REST est pour bientôt, en plus des fonctions SQL et Python existantes. Les équipes métier peuvent utiliser une interface de langage naturel simple dans Document AI (bientôt disponible pour tous nos clients) pour extraire du contenu et des valeurs analytiques à partir de PDF et d’autres documents sans avoir besoin d’expertise en IA.

- Créer facilement une IA générative spécifique à un cas d’usage : pour aider les entreprises à améliorer les performances des LLM et à offrir des expériences plus personnalisées sans complexité opérationnelle, le fine-tuning serverless des modèles de fondation est maintenant en public preview. Le fine-tuning peut être exécuté à la fois via une expérience no-code dans Snowflake AI & ML Studio ou à l'aide de l'API basée sur le code.

- Accélérez et dimensionnez les opérations de caractéristiques et de modèles : développer, déployer et gérer des caractéristiques et des modèles à grande échelle devient plus simple. Cela est possible avec les Notebooks, dont l’exécution automatisée (public preview) peut être planifiée, Snowflake Feature Store (public preview), pour rationaliser l’utilisation et la gestion des fonctionnalités, et Snowflake Model Registry, pour gérer les modèles entraînés dans Snowflake ou toute autre plateforme. De même qu’offrir une expérience unifiée à tous les modèles personnalisés, y compris les LLM affinés à l’aide de Snowflake Cortex AI.

Parlez à vos données avec une IA de pointe

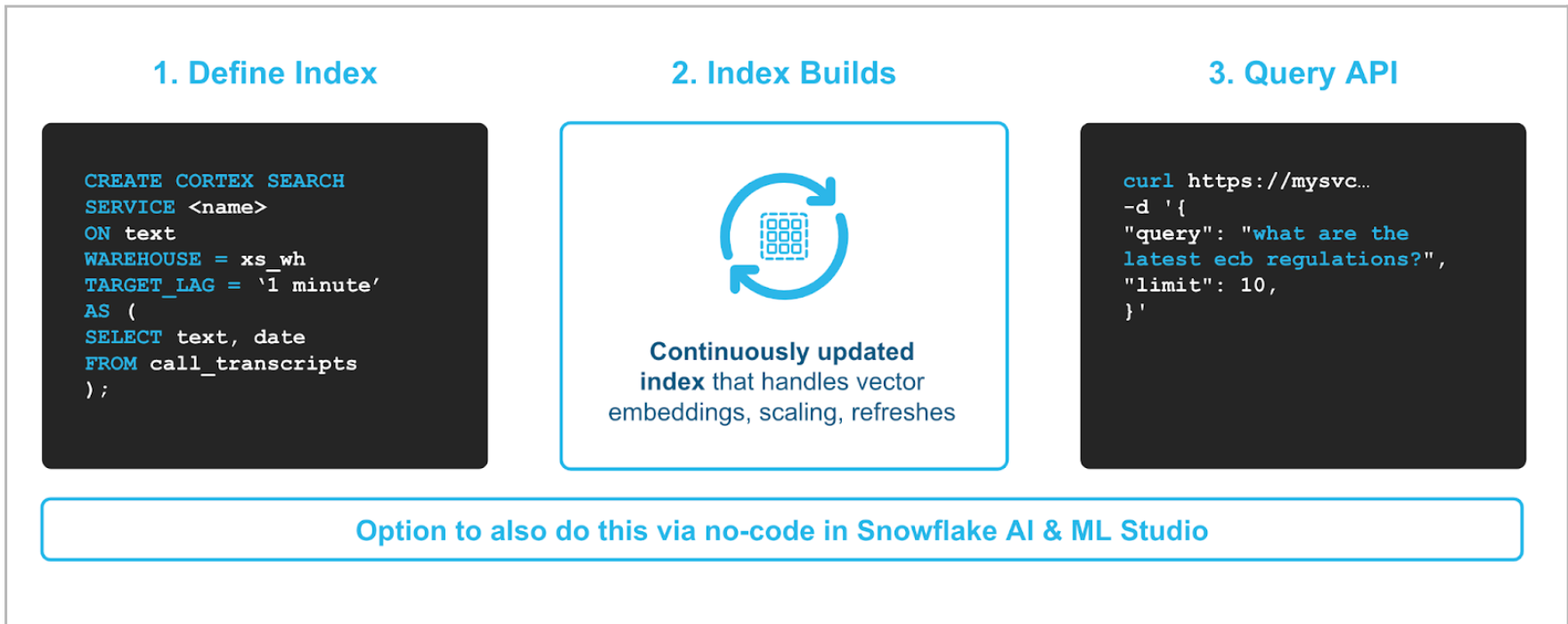

Cortex Search, bientôt en public preview, permet de parler à des documents et à d’autres jeux de données textuelles, comme des wikis et des FAQ, aussi facilement que d’exécuter une fonction SQL. L’implémentation de votre service de recherche documentaire ne prend que quelques clics à l'aide de Studio ou d'une seule commande, où vous définissez les documents à mettre à disposition de la recherche (voir Figure 1).

Pour fournir des résultats plus précis, Cortex Search utilise des techniques de pointe en matière de récupération et de classement. Grâce à une combinaison de recherche sémantique et de recherche par mots clés, basée sur la technologie de pointe de Neeva et des modèles Arctic Embed, conçus par l’équipe de recherche en IA de Snowflake, Cortex Search est en mesure de fournir aux utilisateurs des résultats de haute qualité sans complexité opérationnelle. Cortex Search peut évoluer vers des millions de documents avec une latence inférieure à la seconde, grâce à l’intégration et à la récupération vectorielles entièrement gérées. Il n’est pas nécessaire de configurer ou de gérer une base de données vectorielle séparée.

Cortex Analyst, bientôt en public preview, permet aux développeurs d’applications de créer des applications à partir de données analytiques stockées dans Snowflake, afin que les utilisateurs métiers puissent obtenir les informations dont ils ont besoin en posant simplement leurs questions dans un langage naturel. Comparé à Snowflake Copilot, qui aide les développeurs SQL à accélérer le développement à partir de Snowsight en transformant du texte en SQL, Cortex Analyst est conçu pour transformer des questions en réponses et ce, à partir de n’importe quelle application avec laquelle les utilisateurs métiers interagissent au quotidien. Pour fournir les niveaux élevés de précision auxquels les utilisateurs professionnels s’attendent afin de faire confiance aux résultats et de prendre des mesures en conséquence, Snowflake gère les tâches les plus complexes, combinant les LLM de pointe de Meta et Mistral AI, et demande uniquement aux développeurs de fournir un modèle sémantique pendant la configuration. Ce modèle sémantique permet de fournir un contexte supplémentaire sur la terminologie spécifique et la structure de modélisation des données de l'entreprise.

Donnez l'accès à l'IA à plus d'équipes

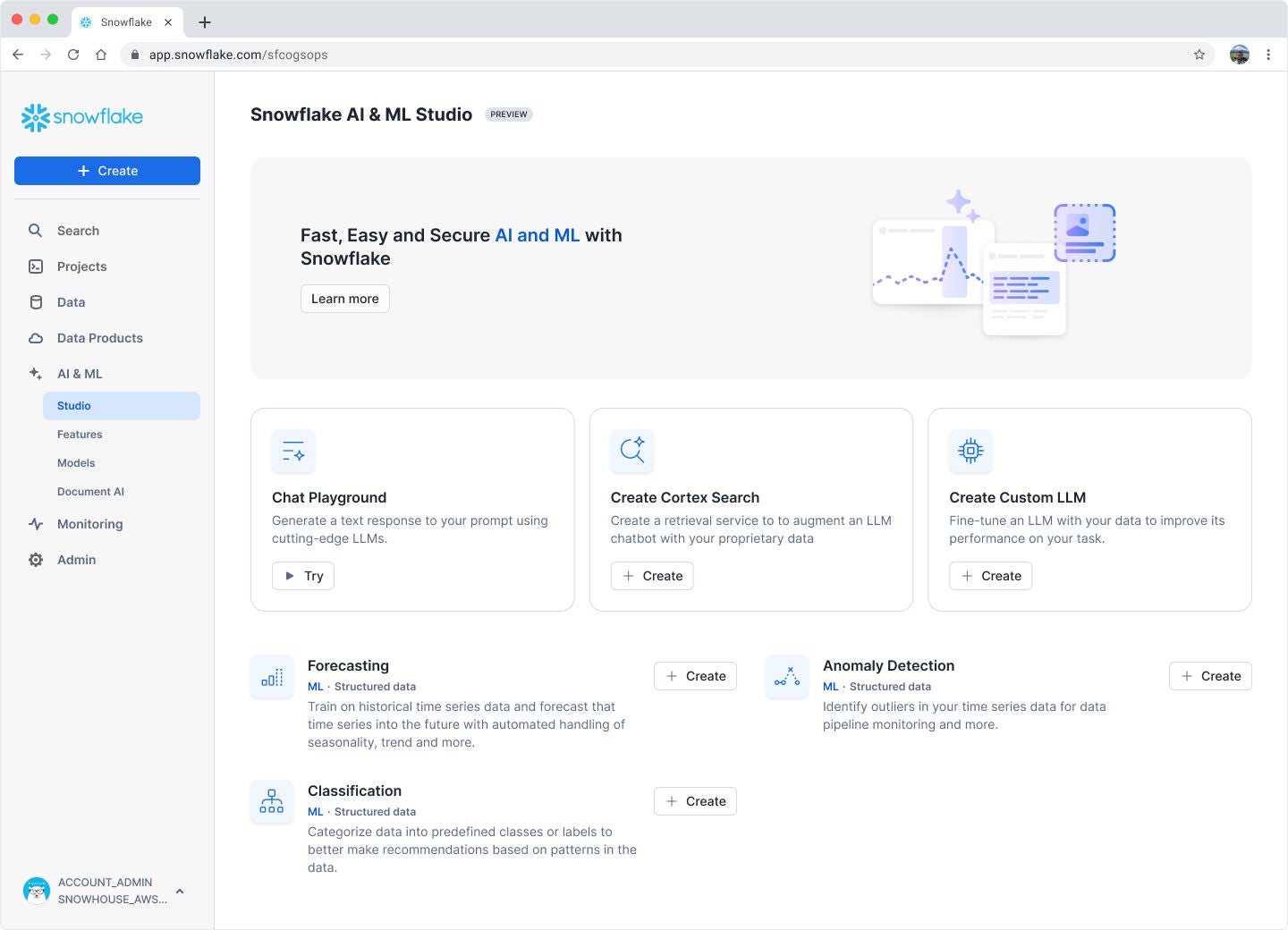

Snowflake AI & ML Studio, en private preview pour les LLM, intègre le développement no-code de l’IA dans Snowflake. Studio est accessible dans Snowsight pour accéder à des interfaces interactives permettant aux équipes de combiner rapidement plusieurs modèles avec leurs données et de comparer les résultats pour accélérer le déploiement sur les applications en production. Certaines des expériences interactives de Studio incluent la possibilité de créer des modèles de machine learning, comme les prévisions, et à l'avenir inclura également une interface pour comparer et évaluer les réponses de plusieurs LLM à partir d'une seule prompt, exécuter le fine-tuning des LLM et plus encore. En particulier pour les cas d’usage de l’IA générative, cette expérience no-code permet aux équipes d’évaluer et de sélectionner plus facilement le modèle de pointe le plus adapté à leur tâche et à leurs objectifs de coûts.

Snowflake Notebooks permet d’accélérer les flux de travail de ML. L’intégration transparente du suivi des expériences avec Weights & Biases directement dans les notebooks élimine le changement de contexte et rationalise l’ensemble du cycle de vie du machine learning pour la création et le déploiement de modèles. Nous sommes impatients de voir comment cette intégration permet à nos clients de gagner en efficacité.

Venky Yerneni, Manager, Solution Architecture, Weights & Biais

Snowflake Notebooks est désormais disponible en public preview pour permettre aux équipes data, maîtrisant SQL, Python ou les deux, d’exécuter des analyses interactives, d’entraîner des modèles ou d’évaluer des LLM dans un environnement cellulaire intégré. Cette expérience de développement interactif élimine les limites de traitement du développement local ainsi que les risques sécuritaires et opérationnels liés au transfert des données vers un outil séparé. Et comme les notebooks sont intégrés aux bibliothèques Streamlit, il est facile de prendre le code développé dans un notebook et de le déployer dans Streamlit in Snowflake pour partager les informations sous forme d’applications interactives.

Pour en savoir plus sur l’utilisation des notebooks, consultez notre documentation ou ce quickstart.

Document AI est bientôt disponible pour tous nos clients et offre un nouvel environnement pour extraire facilement du contenu (montants facturés, conditions contractuelles, etc.) des documents à l’aide d’Arctic TILT, un LLM multimodal intégré de pointe. Les utilisateurs métiers non techniques peuvent utiliser l'interface de langage naturel pour définir l'ensemble des champs ou des valeurs à extraire et, si nécessaire, affiner le modèle pour mieux comprendre des formats de documents spécifiques. Pour extraire en continu l’ensemble de champs voulu au fur et à mesure que de nouveaux documents arrivent, le modèle peut ensuite être exécuté via la fonction SQL PREDICT par les data engineers ou les ML engineers qui opérationnalisent le modèle dans des pipelines qui alimentent les modèles d’analyse ou de ML en aval.

L'IA générative personnalisée simple et sécurisée

Snowflake Cortex fine-tuning, en public preview, prend en charge la personnalisation sécurisée et serverless d’un sous-ensemble de modèles Meta et Mistral AI. Une fois les données prêtes, lancer le processus de fine-tuning est aussi simple que d’exécuter une fonction SQL ou quelques clics via Snowflake AI & ML Studio, sans avoir à gérer d’infrastructure. Les modèles affinés ne sont disponibles que par défaut et peuvent être partagés avec d’autres personnes à l’aide de politiques définies à l’aide de Snowflake Model Registry. Les utilisateurs ayant accès aux modèles personnalisés pourront les utiliser aussi facilement que n’importe quel autre LLM pris en charge par Cortex en utilisant la fonction COMPLETE dans Cortex AI.

Consultez notre documentation pour plus de détails sur la tarification et les modèles pris en charge.

Cortex Guard est bientôt disponible pour tous nos utilisateurs afin de filtrer les contenus nuisibles associés à la violence et à la haine, à l’automutilation et aux activités criminelles. Les contrôles de sécurité peuvent être appliqués facilement à n'importe quel LLM dans Cortex AI en utilisant les garde-fous qui font désormais partie de la fonction COMPLETE. Grâce à Cortex Guard, les entreprises peuvent rapidement mettre en œuvre les contrôles de sécurité nécessaires pour fournir l'IA générative dans les applications en production.

Accélérez et dimensionnez les opérations de modèles et de caractéristiques

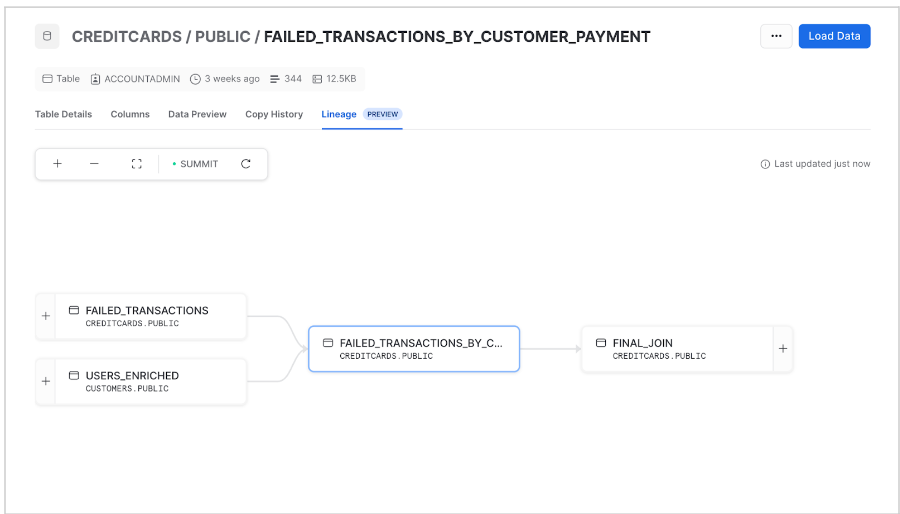

Snowflake Horizon ML Lineage, en private preview, aide les équipes à établir la traçabilité de bout en bout des caractéristiques, des jeux de données et des modèles, des données aux informations, pour une reproductibilité fluide et une observabilité simplifiée. Pour cartographier rapidement la relation entre les données et les modèles, une interface de visualisation sera disponible dans Snowsight.

Feature Store, en public preview, est une solution intégrée et centralisée pour définir, gérer, stocker et découvrir des caractéristiques. Cette solution, qui fait partie de la suite plus large de composants de Snowflake ML, assure la cohérence et la précision entre les différents pipelines et équipes de ML, que les caractéristiques soient utilisées pour l’entraînement de modèles ou l’exécution de l’inférence. Dans le cadre de cette public preview, les caractéristiques peuvent être définies et gérées à l’aide de l’API Snowpark ML via Snowflake Notebooks ou tout IDE. Le Feature Store rafraîchit automatiquement les données de sources batch et streaming selon le calendrier défini par l’utilisateur, fournissant ainsi aux équipes les informations les plus récentes.

Découvrez dans notre documentation comment vous lancer.

L’utilisation de Snowflake ML nous a permis de franchir une étape majeure dans notre vision de la data et de l’IA et d’offrir à nos clients des expériences personnalisées, individuelles et vraies. Nous avons pu réduire nos coûts de 70 % et gagner en agilité en passant d'une exécution de tâches d'inférence d'une heure à des prévisions en temps quasi réel.

Stefan Kochi, CTO, Paytronix

Model Registry est disponible pour tous nos clients et facilite la gouvernance de tous les modèles de ML, que vous les ayez entraînés dans Snowflake ou dans un autre système de ML. En ajoutant des modèles à Snowflake, les équipes bénéficient d’un hub centralisé pour gérer les modèles et leurs métadonnées associées, mais aussi d’une inférence plus efficace en exécutant les modèles là où les caractéristiques de production sont stockées et gérées.

Pour voir à quel point il est facile d’entraîner et de gouverner des modèles de ML dans Snowflake, consultez ce quickstart.

Ressources pour en savoir plus

En disposant d’une plateforme unifiée avec des contrôles d’accès granulaires pour les données et les modèles, les équipes peuvent accélérer le rythme auquel elles introduisent l’IA dans chaque secteur de leur entreprise de manière efficace, simple et fiable.

Essayez vous-même avec nos quickstarts pour l’IA générative et le ML